Por muy buenas que sean las predicciones del aprendizaje profundo, nadie sabe cómo llega a sus conclusiones. Este hecho está empezando a generar un problema de confianza y las herramientas para resolverlo no están ayudando demasiado. Pero tal vez así es la propia naturaleza de la inteligencia.

El año pasado, un extraño coche autónomo fue liberado en las tranquilas calles de Monmouth County (EEUU). El prototipo, que fue desarrollado por investigadores del fabricante de chips Nvidia, no tenía un aspecto muy distinto al resto de coches autónomos y, sin embargo, no se parecía a nada de lo que han hecho Google, Tesla o General Motors. Además, era una prueba del poder cada vez mayor de la inteligencia artificial (IA). El coche no seguía las indicaciones de un ingeniero o un programador. En su lugar, dependía de un algoritmo que se había enseñado a conducir a sí mismo al observar a un conductor humano.

Hacer que el coche aprendiera a conducir bajo este enfoque fue una hazaña impresionante. Pero también resulta algo desconcertante, ya que no está claro cuál es su mecanismo para la toma de deciciones. Los datos que recogen los sensores del vehículo entran directamente en una enorme red de neuronas artificiales que los procesan. A partir de ellos, el ordejador decide qué hará y envia las órdenes correspondientes al volante, los frenos y otros sistemas para que las lleven a cabo. El resultado parece igualar el comportamiento que se esperaría de un conductor humano. Pero, ¿y si algún día hiciera algo inesperado como chocar contra un árbol, o quedarse inmóvil ante un semáforo en verde? Tal y como están las cosas ahora mismo, podría resultar difícil averiguar por qué hace lo que hace. El sistema es tan complejo que incluso los ingenieros que lo diseñaron podrían ser incapaces de aislar la razón de cualquier acción determinada. Y no se le puede preguntar: no existe ninguna manera obvia de diseñar un sistema para que pueda explicar el por qué de lo que ha hecho (ver Se acabó la confianza ciega, la inteligencia artificial debe explicar cómo funciona).

La misteriosa mente de este vehículo señala un problema cada vez más palpable de la inteligencia artificial. La tecnología de IA del coche, conocida como aprendizaje profundo ha tenido mucho éxito resolviendo problemas en los últimos años, y cada vez se usa más en labores como generar subtítulos, reconocer la voz y traducir idiomas. Estas mismas técnicas podrían llegar a ser capaces de diagnosticar enfermedades mortales, tomar decisiones bursátiles multimillonarias y transformar industrias al completo.

Pero esto no sucederá (o no debería) a menos que consigamos que las técnicas como el aprendizaje profundo resulten más comprensibles para sus creadores y rindan cuentas ante los usuarios. En caso contrario, resultará difícil predecir cuándo se podrían producir fallos, los cuales son inevitables. Este es uno de los motivos por los que el coche de Nvidia aún es experimental.

Ya se están empleando modelos matemáticos para ayudar a determinar quién recibe la libertad condicional, quién es apto para obtener préstamos y quién es contratado para ocupar un puesto vacante. Si se pudiese acceder a estos modelos matemáticos, sería posible entender su razonamiento. Pero los bancos, el ejército y los empleadores están centrándose en enfoques de aprendizaje automático aún más complejos que podrían resultar totalmente inescrutables. El aprendizaje profundo, el más común de estos enfoques, representa una manera fundamentalmente distinta de programar los ordenadores. «Ya es un problema relevante, y lo va a ser mucho más en el futuro», afirma el profesor del Instituto Tecnológico de Massachusetts (MIT, EEUU) Tommi Jaakkola, que trabaja en aplicaciones del aprendizaje automático. El experto añade: «Tanto si es una decisión de inversión, médica o militar, nadie quiere tener que depender de un método de ‘caja negra'».

Ya hay argumentos que defienden que la capacidad de interrogar a un sistema de inteligencia artificial sobre cómo llegó a sus conclusiones representa un derecho legal básico. A partir del verano de 2018, la Unión Europea podría obligar a las empresas a que ofrezcan una respuesta a sus ususarios sobre las decisiones a las que llegan los sistemas automatizados. Esto podría resultar imposible, incluso para sistemas aparentemente sencillos, como las apps y páginas web que emplean el aprendizaje profundo para mostrar anuncios y recomendar canciones. Los ordenadores que ejecutan esos servicios se han autoprogramado y ni siquiera sabemos cómo. Incluso los ingenieros que desarrollan estas apps son incapaces de explicar totalmente su comportamiento.

Esto suscita algunas preguntas inquietantes. A medida que la tecnología avance podríamos cruzar un umbral a partir del cual utilizar la IA requiera un salto de fe. Claro que los humanos no siempre podemos explicar realmente nuestros procesos cognitivos tampoco, pero encontramos maneras de confiar en y juzgar a la gente de forma intuitiva. ¿También será posible eso con máquinas que piensan y toman decisiones de manera distinta a los humanos? Nunca habíamos desarrollado máquinas que trabajan sin que sus creadores entiendan cómo. ¿Esperamos llevarnos y comunicarnos bien con máquinas inteligentes que podrían ser impredecibles e inescrutables? Estas preguntas me empujaron a emprender un viaje hasta la frontera de las investigaciones sobre algoritmos de inteligencia artificial, desde Google hasta Apple, pasando por muchos sitios entre medias, incluida una reunión con uno de los grandes filósofos de nuestro tiempo.

En 2015, un grupo de investigadores del Hospital Monte Sinaí de Nueva York (EEUU) quiso aplicar el aprendizaje profundo a la vasta base de datos de historiales de pacientes del hospital. Este conjunto de datos incluye cientos de variables, procedentes de los resultados de pruebas, consultas médicas y mucho más. El programa resultante, que los investigadores llamaron Deep Patient, fue entrenado con datos de alrededor de 700.000 individuos, y cuando fue probado con historiales nuevos, resultó ser increíblemente bueno a la hora de precedir enfermedades. Sin ninguna formación por parte de expertos, Deep Patient había descubierto patrones ocultos dentro de los datos del hospital que parecían indicar cuándo la gente estaba a punto de desarrollar un amplio abanico de trastornos, incluido el cáncer de hígado. Hay muchos métodos para predecir enfermedades a partir del historial médico de un paciente que rinden «bastante bien», según el líder del equipo, Joel Dudley. Pero, añade: «Esto simplemente era mucho mejor».

«Podemos elaborar estos modelos, pero no sabemos cómo funcionan»

Al mismo tiempo, Deep Patient es algo desconcertante. Parece anticipar el comienzo de trastornos psiquiátricos como la esquizofrenia bastante bien. Pero dado que es un trastorno que a los médicos les cuesta mucho predecir, Dudley no entendía los resultados de su algoritmo. Y sigue sin hacerlo. La nueva herramienta da pistas sobre cómo lo hace. Si algo como Deep Patient puede ayudar a los médicos, lo ideal sería que compartiera el razonamiento que le ha llevado hasta su predicción para asegurarse de que es precisa y poder justificar, por ejemplo, un cambio en la medicación que recibe un paciente. Con una sonrisa algo triste, Dudley afirma: «Podemos desarrollar estos modelos, pero no sabemos cómo funcionan».

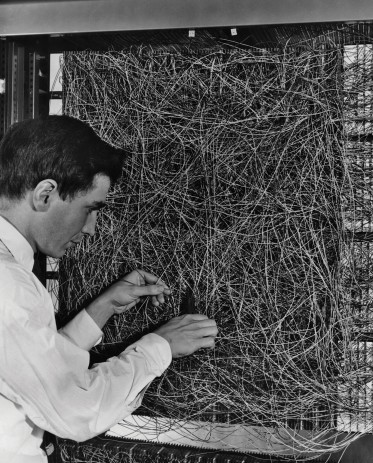

La inteligencia artificial no siempre ha sido así. Desde un principio, ha habido dos escuelas de pensamiento respecto a lo entendible, o explicable, que debería ser. Muchos creían que tenía sentido desarrollar máquinas que razonaran de acuerdo a reglas y lógica, lo que volvería transparente su funcionamiento interno para cualquiera que quisiera examinar el código. Otros sentían que la inteligencia avanzaría más si las máquinas se inspiraran en la biología, y aprendieran mediante la observación y la experiencia. Esto significaba invertir la programación informática. En lugar de que un programador escribiera los comandos para resolver un problema, el programa genera su propio algoritmo en base a datos de ejemplo y el resultado deseado. Las técnicas de aprendizaje automático que evolucionaron para convertirse en los sistemas de IA más potentes de la actualidad siguieron el segundo camino: básicamente, la máquina se autoprograma.

Al principio, este enfoque no tenía demasiadas aplicaciones, y durante las décadas de 1960 y 1970 seguía ocupando la periferia del campo. Entonces la informatización de muchas industrias y la llegada del big data renovaron el interés. Eso inspiró el desarrollo de técnicas de aprendizaje automático más potentes, especialmente nuevas versiones de una técnica conocida como red neuronal artificial. Para finales de la década de 1990, las redes neuronales podían digitalizar automáticamente caracteres escritos a mano.

Pero no fue hasta principios de esta década, tras varios ingeniosos ajustes y refinamientos, cuando las redes neuronales muy grandes, o «profundas», empezaron a ofrecer drásticas mejoras en la percepción automatizada. El aprendizaje profundo es responsable de la explosión actual de la IA. Ha dotado los ordenadores de poderes extraordinarios, como la capacidad de reconocer las palabras habladas casi igual de bien que cualquier persona, algo demasiado complejo para ser codificado a mano. El aprendizaje profundo ha transformado la visión de máquinas y mejorado muchísimo la traducción automatizada. Ya contribuye en la toma de todo tipo de decisiones claves en la medicina, las finanzas, la fabricación y mucho más.

El funcionamiento de cualquier tecnología de aprendizaje automático es inherentemente más opaco que un sistema codificado a mano, incluso para los informáticos. Esto no quiere decir que todas las futuras técnicas de IA vayan a resultar igual de imposibles de entender. Pero, por su naturaleza, el aprendizaje profundo es una caja negra especialmente oscura.

Simplemente no es posible adentrarse en las entrañas de una red neuronal profunda para comprobar cómo funciona. Su razonamiento está arraigado en el comportamiento de miles de neuronas simuladas, dispuestas en docenas o incluso cientos de capas intricadamente interconectadas. Las neuronas de la primera capa reciben informaciones, como la intensidad de un píxel dentro de una imagen, y después realizan un cálculo antes de emitir una nueva señal. Estas señales alimentan las neuronas de la próxima capa de una compleja red, y así sucesivamente hasta generar un resultado final. Además, hay un proceso conocido como propagación hacia atrás que ajusta los cálculos de neuronas individuales para que la red aprenda a producir un resultado deseado.

Las múltiples capas de una red profunda la habilitan para reconocer cosas a muchos niveles distintos de abstracción. En un sistema diseñado para reconocer perros, por ejemplo, las primeras capas reconocen elementos muy básicos como contornos y colores; las siguientes capas reconocen cosas más complejas como el pelo o los ojos; y las capas superiores objetos al completo, como un perro. El mismo enfoque puede aplicarse a otras áreas que permiten que las máquinas se enseñen a sí mismas: los sonidos que componen las palabras dentro del habla, las letras y palabras que generan frases dentro de un texto o los movimientos de volante requeridos para la conducción.

«Simplemente podría ser una parte de la propia naturaleza de la inteligencia el hecho de que sólo una fracción está sujeta a explicaciones racionales. Parte de ella es simplemente instintiva»

Se han empleado ingeniosas estrategias para intentar captar y explicar en mayor detalle lo que sucede dentro de estos sistemas. En 2015, unos investigadores de Google modificaron un algoritmo de reconocimiento de imágenes por aprendizaje profundo para que en lugar de divisar objetos dentro de las fotos los generara o modificara. Al ejecutar el algoritmo al revés, descubrieron las características que el programa emplea para reconocer un pájaro o un edificio. Las imágenes resultantes, producidas por un proyecto conocido como Deep Dream, mostraban animales grotescos con aspecto alienígena emergiendo de nubes y plantas, y pagodas alucinatorias que poblaban bosques y cordilleras. Las imágenes demostraron que el aprendizaje profundo no tiene por qué ser del todo inescrutable. Revelaron que los algoritmos se centran en características visuales familiares como el pico o las plumas de un pájaro. Pero las imágenes también ofrecieron pistas de lo mucho que difiere de la percepción humana, ya que podrían tomar decisiones basadas en elementos que nosotros sabríamos ignorar. Los investigadores de Google señalaron que cuando su algoritmo generaba imágenes de una mancuerna, también generaba un brazo humano sujetándola. La máquina había concluido que el brazo formaba parte del objeto.

Y la neurociencia y la ciencia cognitiva han logrado aún más avances. Un equipo liderado por el profesor adjunto de la Universidad de Wyoming (EEUU) Jeff Clune ha empleado el equivalente de IA de las ilusiones ópticas para probar redes neuronales profundas.

En 2015, el grupo de Clune demostró cómo ciertas imágenes podían engañar a una red para percibir cosas que no estaban allí, porque las imágenes se aprovechan de los patrones de nivel bajo que el sistema rastrea. Uno de los colaboradores de Clune, Jason Yosinski, también desarrolló una herramienta que actúa como sonda cerebral. Se dirige a cualquier neurona de la red y busca la imagen que más la active. Las imágenes devueltas son abstractas (imagínese una versión impresionista de un flamenco o autobús escolar), lo que, de nuevo, revela la naturaleza misteriosa de las capacidades de percepción de la máquina.

Foto: Ferriss se sintió inspirado a pasar la red neuronal artificial de la Universidad de Cornell por Deep Dream, generando así esta imagen y la de más abajo. Crédito: Adam Ferriss.

Pero no podemos conformarnos con una visión aproximada de cómo funciona la inteligencia artificial, y parece que no hay soluciones fáciles. Lo que resulta crucial para reconocer patrones y tomar decisiones complejas de nivel superior es la interacción de cálculos dentro de una red neuronal profunda. Pero esos cálculos son una ciénaga de funciones y variables matemáticas. «Si tuvieras una red neuronal muy pequeña, tal vez podrías entenderla. Pero en cuanto se vuelve muy grande y presenta miles de unidades por capa y tal vez cientos de capas, entonces se vuelve bastante incomprensible», dice Jaakkola.

En el despacho de al lado al de Jaakkola trabaja la profesora del MIT Regina Barzilay, que está empeñada en aplicar el aprendizaje automático a la medicina. Fue diagnosticada con cáncer de mama hace un par de años, a la edad de 43. El diagnóstico le resultó impactante, pero Barzilay también estaba consternada por el hecho de que los métodos estadísticos más modernos y el aprendizaje automático no estuvieran siendo empleados para apoyar las investigaciones oncológicas ni para guiar los tratamientos de los pacientes. Asegura que la IA tiene un enorme potencial para revolucionar la medicina, pero alcanzar ese potencial significará ir más allá de los historiales médicos. Le gustaría que se emplearan muchos más datos, los cuales asegura que están infrautilizados: «datos de imágenes, datos patológicos, todas estas informaciones», aclara.

¿Esperamos llevarnos y comunicarnos bien con máquinas inteligentes que podrían ser impredecibles e inescrutables?

Después de finalizar su tratamiento el año pasado, Barzilay y sus alumnos empezaron a colaborar con médicos del Hospital General de Massachusetts (EEUU) para desarrollar un sistema capaz de minar los informes de patologías para identificar pacientes con determinadas características que los investigadores tal vez querrían estudiar. Sin embargo, Barzilay entendía que el sistema tendría que explicar su razonamiento. Así que, junto con Jaakkola y un alumno, añadió un paso: el sistema extrae y señala las partes de un texto que más representan el patrón que ha descubierto. Barzilay y sus alumnos también están desarrollando un algoritmo de aprendizaje profundo capaz de identificar las primeras señales del cáncer de mama en imágenes de mamografía y quieren dotarlo de la capacidad de explicar su razonamiento. «Realmente necesitas tener un bucle de colaboración entre la máquina y el humano», explica Barzilay.

El Ejército de Estados Unidos está invirtiendo miles de millones de euros en proyectos que emplearán el aprendizaje automático para pilotar vehículos y aeronaves, identificar objetivos y ayudar a los analistas a procesar enormes cantidades de datos de inteligencia. Aquí, más que en ningún otro sitio, incluso más que en la medicina, existe poco margen para los misterios algorítmicos y el Departamento de Defensa de EEUU considera que la incapacidad de explicarse es un obstáculo clave.

El director de programa de la Agencia de Proyectos de Investigación Avanzados de EEUU (DARPA, por sus siglas en inglés) David Gunning está supervisando el muy bien nombrado Programa de Inteligencia Artificial Explicable. Este veterano de la agencia, de pelo gris y que supervisó el proyecto de DARPA que finalmente dio paso a la creación de Siri, dice que la automatización se está colando en innumerables áreas del ejército. Analistas de inteligencia están probando el aprendizaje automático para identificar patrones en vastas cantidades de datos de vigilancia. Muchos vehículos autónomos terrestres y aéreos están siendo desarrollados y probados. Pero los soldados probablemente no se sentirán cómodos dentro de un tanque robótico del que no saben por qué hace lo que hace, y los analistas se mostrarán reacios a actuar en función de unas recomendaciones generadas sin algún tipo de razonamiento. «A menudo estos sistemas generan muchas falsas alarmas, por lo que un analista de inteligencia realmente necesita una ayuda extra para entender por qué se ha hecho una recomendación», señala Gunning.

El pasado mes de marzo, DARPA escogió 13 proyectos de la academia y la industria para financiarlos bajo el programa de Gunning. Algunos de ellos podrían basarse en el trabajo liderado por el profesor de la Universidad de Washington (EEUU) Carlos Guestrin. Junto a sus compañeros, ha desarrollado una manera de que los sistemas de aprendizaje automático expliquen sus resultados. En esencia, bajo este método un ordenador encuentra automáticamente unos pocos ejemplos dentro de un conjunto de datos y proporciona una corta explicación para ellos. Un sistema diseñado para clasificar un mensaje de correo electrónico como procedente de un terrorista, por ejemplo, podría emplear millones de mensajes en su entrenamiento y proceso de toma de decisiones. Pero mediante el enfoque del equipo de Washington, podría señalar determinadas palabras claves encontradas dentro de un mensaje. El grupo de Guestrin también ha elaborado herramientas para que los sistemas de reconocimiento de imágenes den pistas sobre su razonamiento al señalar las partes de una imagen que resultaron más importantes.

Pero estos enfoques tienen una pega: las explicaciones siempre estarán simplificadas, lo que significa que algunas informaciones vitales podrían perderse por el camino. Guestrin detalla: «No hemos logrado el sueño al completo, que es donde la IA mantiene una conversación contigo y es capaz de explicarse. Aún estamos muy lejos de disponer de una IA verdaderamente interpretable».

Y no es necesario que se trate de temas cruciales, como el diagnóstico de un cáncer, para que esto resulte un problema. Conocer el razonamiento de la IA también será imprescindible si la tecnología aspira a formar parte de la vida diaria de las personas. El líder del equipo de Siri de Apple, Tom Gruber, dice que el carácter explicable es una consideración clave para su equipo en sus esfuerzos por hacerla más inteligente y hábil. Gruber no quiso hablar de planes específicos para el futuro de Siri, pero resulta fácil imaginar que al recibir una recomendación de un restaurante, se quiera conocer el razonamiento subyacente. El director de investigaciones de IA de Apple y profesor de la Universidad de Carnegie Mellon (EEUU), Ruslan Salakhutdinov, considera que la capacidad de explicarse es el núcleo de la relación en evolución entre los humanos y las máquinas inteligentes. «Va a generar confianza», afirma.

Al igual que muchos aspectos del comportamiento humano resultan imposibles de explicar en detalle, tal vez no será posible que la inteligencia artificial llegue a explicar todo lo que hace. «Incluso si alguien te puede dar una explicación razonable [de sus acciones], probablemente estará incompleta, y lo mismo podría aplicarse a la inteligencia artificial», sugiere Clune. El experto añade: «Simplemente podría ser una parte de la propia naturaleza de la inteligencia el hecho de que sólo una fracción está sujeta a explicaciones racionales. Parte de ella es simplemente instintiva, o subconsciente o inescrutable».

En tal caso, tal vez llegue un momento en el que debamos decidir si confiamos ciegamente en la IA o desechamos su uso. Igualmente, esa misma decisión tendrá que incorporar inteligencia social. Al igual que la sociedad se construye sobre una base de comportamientos aceptables, necesitaremos diseñar los sistemas de IA para respetar y encajar con nuestras normas sociales. Si vamos a crear tanques robóticos y otras máquinas de matar, es importante que su toma de decisiones concuerde con nuestros juicios éticos.

Para explorar estos conceptos metafísicos, acudí a la Universidad de Tufts (EEUU) para reunirme con el filósofo de renombre y científico cognitivo Daniel Dennett, que estudia la consciencia y la mente. Un capítulo de su último libro, From Bacteria to Bach and Back, un tratado enciclopédico sobre la consciencia, sugiere que una parte natural de la evolución de la propia inteligencia consiste en desarrollar sistemas capaces de ejecutar tareas que sus creadores son incapaces de ejecutar. «La pregunta es: ¿qué adaptaciones tenemos que hacer para hacerlo bien, qué estándares debemos exigirles que cumplan a ellos, y a nosotros mismos?», me pregunta dentro de su abarrotado despacho en el idílico campus de la universidad.

También me hizo una advertencia sobre la búsqueda del carácter explicable: «Creo que si vamos a utilizar estas cosas y depender de ellas, entonces necesitamos el mejor entendimiento posible de cómo y por qué nos proporcionan respuestas», sugiere. Pero, puesto que podría no existir ninguna respuesta perfecta, deberíamos mostrarnos igual de cautelosos ante las explicaciones de la IA como nos mostramos ante las explicaciones humanas, independientemente de lo lista que parezca la máquina. Dennet concluye: «Si no puede explicar lo que hace mejor que nosotros, entonces no te fíes».