La vida diaria durante una pandemia implica distanciamiento social y encontrar nuevas formas de conectarse de forma remota con amigos, familia y compañeros de trabajo. Esto supone grandes horas de nuestros tiempo dedicada a comunicarnos a través de diferentes servicios donde existen ciertos grados de Inteligencia Artificial (IA) implicados. Desde los correctores de textos que muestran posibles respuestas a preguntas simples, a aplicaciones más sofisticadas que tienen en cuenta tu historial de conversación para dar respuestas más afinadas, la IA se inmiscuye en estas conversaciones de formas que nos podemos esperar. Un grupo de investigadores de la Universidad de Cornell ha querido investigar los efectos de la comunicación mediada a través de una IA. Sus resultados tienen ahora una especial relevancia al tener la mayoría de conversaciones diarias online debido al confinamiento.

El estudio es un intento de explorar las innumerables formas en la que los sistemas de IA y sus respuestas están alterando la forma en que interactúan los humanos. Por ejemplo, “elegir una respuesta sugerida que no es exactamente lo que se pretendía decir, pero que le ahorra teclear, podría estar alterando fundamentalmente el curso de sus conversaciones y sus relaciones”, señalan los investigadores.

La comunicación mediada por IA representa un nuevo paradigma en el que la comunicación es aumentada o generada por un sistema inteligente. A medida que esta se hace más frecuente, es importante entender los efectos que tienen en las interacciones humanas y en las relaciones interpersonales.

«Este estudio se enmarca en una agenda más amplia para entender cómo estos nuevos sistemas de IA condicionan con nuestra capacidad de interactuar. A menudo pensamos en cómo el diseño de los sistemas afecta a la forma en que interactuamos con ellos, pero menos estudios se centran en la cuestión de cómo las tecnologías que desarrollamos afectan a la forma en que las personas interactúan entre sí» explica el co-autor del estudio Malte Jung, profesor asistente de ciencias de la información y director del laboratorio Robots en Grupos, que explora cómo los robots alteran la dinámica de grupo.

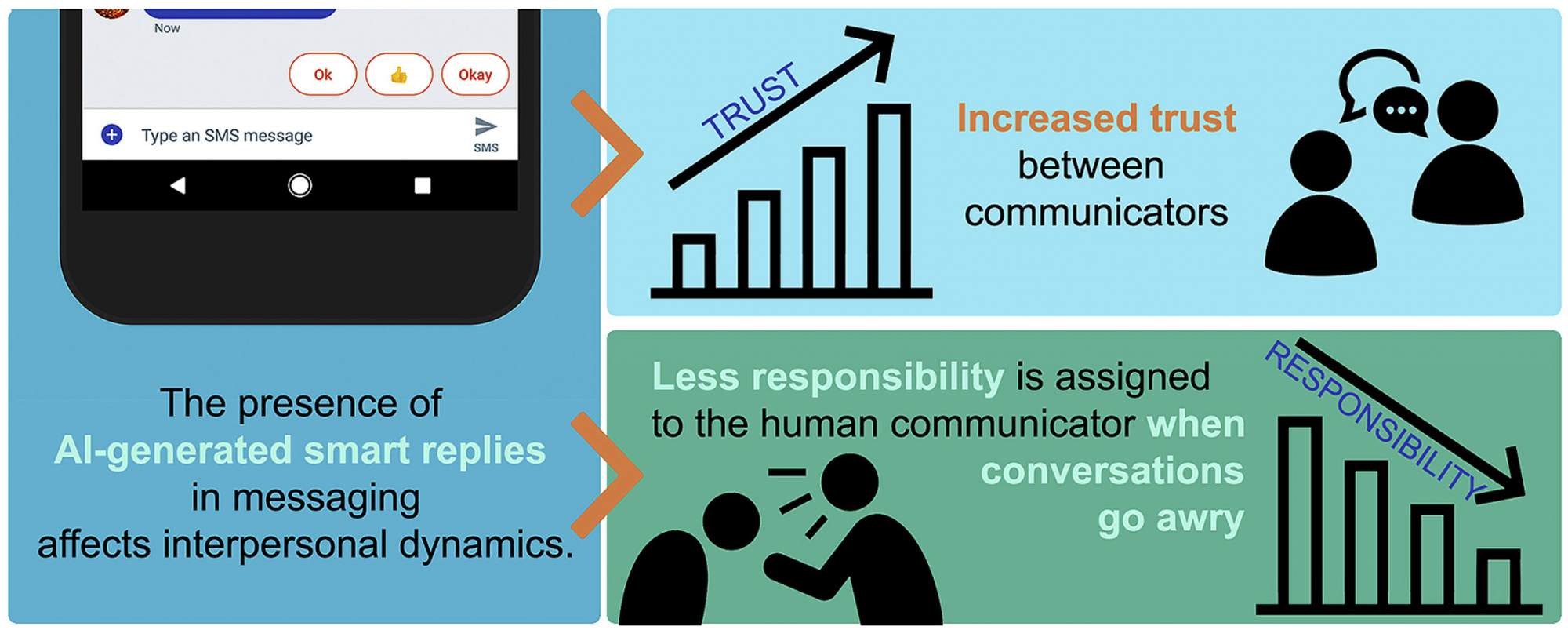

Trabajos anteriores muestran que en las interacciones humanas con los sistemas inteligentes, la mala atribución es común y la confianza se desarrolla y se maneja de forma diferente que entre las interacciones entre humanos. El nuevo estudio demuestra que la presencia de respuestas inteligentes generadas por la IA sirve para aumentar la confianza percibida entre los comunicadores humanos y que, cuando las cosas se tuercen, la IA parece ser percibida como un agente coercitivo, lo que le permite funcionar como una “zona de contracción moral” y disminuir la responsabilidad asignada al otro comunicador humano.

La IA como mediadora en las comunicaciones online

Para el estudio, los investigadores utilizaron Google Alto, una aplicación de mensajería de inteligencia artificial ya desaparecida que sugiere respuestas inteligentes basadas en un algoritmo y el historial de conversación. A los 113 estudiantes universitarios que participaron se les dijo que estarían chateando con otro participante para completar una tarea, pero sus parejas en realidad controlaban la dinámica de las conversaciones usando guiones preescritos. La tarea requería que las parejas clasificaran a cinco de nueve personas para los puestos en un bote salvavidas.

Había cuatro versiones diferentes de las conversaciones: exitosa con respuestas de la IA; infructuosa con la IA; y exitosa o infructuosa sin la IA. Después de que los participantes completaran o no la tarea, se les pedía que asignaran un porcentaje de responsabilidad por el resultado de la tarea a ellos mismos, a su pareja y, en las conversaciones mediadas por la IA, al sistema de IA. También se les pidió que calificaran su nivel de confianza en su pareja y en la IA.

Descubrieron que la IA afectaba a los resultados, tanto si las conversaciones tenían éxito como si no. En las conversaciones exitosas, la confianza de los participantes en sus parejas era de 4,8 sobre 6; en las conversaciones con éxito mediadas por la IA, era de 5,76. En las conversaciones sin éxito, los participantes confiaban más en la IA (3,13) que en sus parejas (3,04).

«Existe la teoría de que ya estamos asignando características humanas a las computadoras, por lo que se deduce que cuando interactuamos con un humano mediado por este sistema artificialmente inteligente, le asignaríamos algunas características humanas», dijo Hohenstein. «Pero aún así, estos resultados no son lo que esperábamos».

Además de arrojar luz sobre la forma en que las personas perciben e interactúan con las computadoras, el estudio ofrece posibilidades de mejorar la comunicación humana, con una sutil guía y recordatorios de la IA.

Los investigadores dijeron que buscaban explorar si la IA podía funcionar como una «zona de contracción moral» – el equivalente tecnológico de la zona de contracción de un coche, diseñada para deformarse con el fin de absorber el impacto del choque.

«Hay un mecanismo físico en la parte delantera del coche que está diseñado para absorber la fuerza del impacto y asumir la responsabilidad de minimizar los efectos del choque.Aquí vemos que el sistema de IA puede absorber parte de la responsabilidad moral, y utilizarse como herramienta para mejorar las relaciones y las percepciones de los resultados de las conversaciones entre los interlocutores», concluyen los investigadores.